音频转文字技术,通常被称为自动语音识别(ASR),是计算机科学和人工智能领域的重要研究方向。随着深度学习和神经网络的发展,这一技术得到了显著的进步。本文将深入探讨音频转文字的算法与原理,以帮助读者更好地理解这一复杂的过程。

首先,音频信号的处理是实现语音识别的第一步。原始音频信号是连续的波形数据,因此需要通过数字信号处理(DSP)技术将其转换为离散的数据形式。这一过程包括采样、量化和编码等步骤。采样是指以一定的时间间隔对声音信号进行取样,而量化则是将这些取样值映射到有限的数值范围内。

在获得离散数据后,接下来的任务是特征提取。常用的方法包括梅尔频率倒谱系数(MFCC)和感知线性预测(PLP)。这些特征能够有效地捕捉到语音信号中的重要信息,同时减少噪声干扰,为后续的模型训练提供高质量的数据输入。

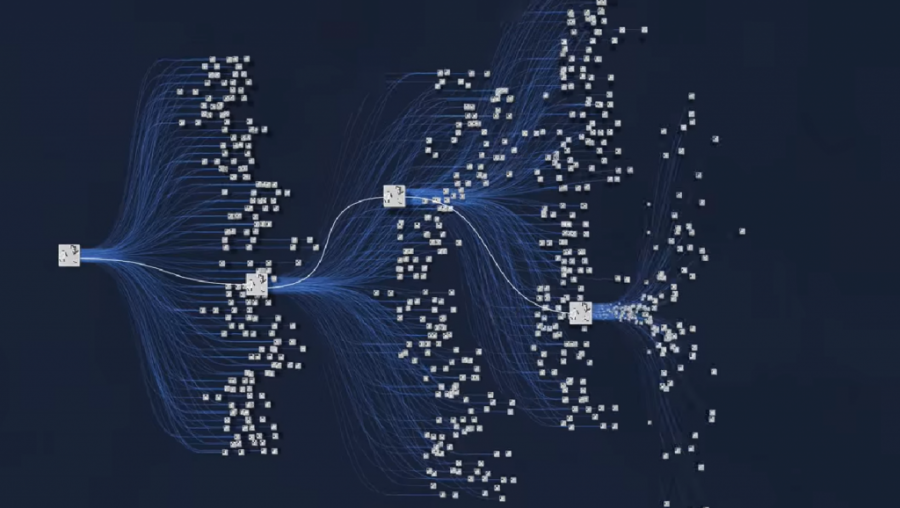

随着深度学习技术的发展,许多现代语音识别系统采用了基于神经网络的方法。其中,循环神经网络(RNN)和长短期记忆网络(LSTM)因其在处理序列数据方面的优势而被广泛应用。这些模型能够考虑到语音信号中的时间依赖性,从而提高识别准确率。此外,卷积神经网络(CNN)也开始逐渐应用于特征提取阶段,以提升模型对不同说话风格和环境噪声的适应能力。

在训练过程中,模型通过大量标注好的语音数据进行学习。具体来说,通过最小化预测输出与真实标签之间的损失函数来调整模型参数。这一过程通常采用随机梯度下降(SGD)或其变种,如Adam优化器,以加速收敛并提高效率。

值得注意的是,在实际应用中,背景噪声、说话人的口音、说话速度以及语言本身的复杂性都会影响识别效果。因此,为了提高系统鲁棒性,一些方法如数据增强、迁移学习及自适应训练等被引入。这些策略可以帮助系统更好地适应不同场景,提高整体性能。

最后,在完成模型训练后,需要进行解码,将经过处理后的特征序列转换为文本。这一过程通常涉及语言模型,它利用统计学或深度学习方法来评估词序列的合理性,从而选择最优解码路径。

总体而言,音频转文字技术是一项集成了多个学科知识的大型工程,其背后的算法与原理相互交织,共同推动着自动语音识别的发展。在未来,我们可以预见这一领域将继续取得突破,为人机交互、信息检索等众多应用场景带来更加便捷、高效的解决方案。